티스토리 뷰

이전에 올린 Barlow Twins Architecture를 구현하면서 tensorflow.keras.Model의 train_step() 함수를 건드릴 일이 생겼는데 해당 함수에서 Gradient Tape를 사용하는 점을 보고 공부하며 아래의 블로그를 필사했습니다.

https://rfriend.tistory.com/556

[TensorFlow] Gradient Tape을 이용한 자동 미분과 오차역전파

자동미분(Automatic differentiation, Algorithmic differentiation, computational differentiation, auto-differentiation, 또는 줄여서 간단히 auto-diff) 은 컴퓨터 프로그램에 의해서 구체화된 함수의 미분을 산술적으로 계산

rfriend.tistory.com

자동미분(Automatic differentiation, Algorithmic differentiation, Computational differentiation, auto-differentiation)은 컴퓨터 프로그램에 의해서 구체화된 함수의 미분을 산술적으로 계산할 때 사용하는 기술의 집합을 말합니다. 컴퓨터 프로그램에 의해서 구제화된 함수는 아무리 복잡해보이더라도 기본적인 산술 연산과 기본적인 함수의 연속적인 실행으로 이루어진다는 아이디어를 기반으로 합니다.

복잡한 함수도 연쇄 법칙(Chain Rule)을 이용함으로써 합성함수를 구성하는 각 기본함수의 미분의 곱으로 나타내고 반복적으로 계산함으로써 자동으로 복잡한 함수를 정확하고 효율적으로 미분이 가능합니다.

자동미분(Automatic Differentiation)은 딥러닝에서 오차 역전파 알고리즘을 사용해서 모델을 학습할 때 유용하게 사용됩니다.

Tensorflow에서는 Gradient Tapes를 이용하여 즉시 실행 모드(eager execution mode)에서 쉽게 오차 역전파를 수행할 수 있습니다.

해당 포스트에는 아래의 5가지에 대하여 소개합니다.

1. 즉시 실행 모드에서 자동미분을 하기 위해 Gradient tapes가 필요한 이유

2. Tensorflow에서 Gradient Tapes를 이용하여 자동 미분을 수행하는 방법

3. 시그모이드(Sigmoid) 함수의 자동 미분 시각화

4. 테이프가 볼 것을 조정하는 방법 (Controlling what the tape wathes)

5. Python 조건절 분기문을 이용한 테이프 기록 흐름 조정(Control Flow)

또한 Tensorflow 튜토리얼의 내용을 변역하고 코드를 대부분 사용하였다고 합니다.

Tensorflow Tutorial URL: https://www.tensorflow.org/guide/autodiff?hl=en

그래디언트 및 자동 미분 소개 | TensorFlow Core

PaLM API 및 MakerSuite Explore Generative AI를 사용 하여 Google의 대규모 언어 모델을 사용해 보세요. 그래디언트 및 자동 미분 소개 컬렉션을 사용해 정리하기 내 환경설정을 기준으로 콘텐츠를 저장하고

www.tensorflow.org

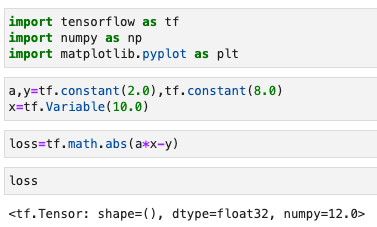

먼저 numpy, tensorflow, matplotlib 모듈을 import합니다.

1. 즉시 실행 모드에서 자동 미분을 하기 위해 Gradient Tapes가 필요한 이유

예를 들어 y=a*x라는 방정식에서 a와 y가 상수(constant)이고 x가 변수(variable)일 때, 이 방정식을 오차 역전파법을 통하여 변수 x를 구하고자 한다고 합시다. 그러면 간단한 손실함수인 loss=abs(a*x-y)를 최소로 하는 x를 구하면 됩니다.

아래 예의 경우 8.0=2.0*x 방정식 함수로부터 변수 x의 값을 구하자고 합시다. x를 10.0에서 시작해서 abs(a*x-y) 손실함수 값을 최소로 하는 x를 구하고자 한다면 '손실함수에 대한 x의 미분(the gradient of the loss with respect to x)'을 구해서 x값을 미분값만큼 빼서 갱신해줘야 합니다.

그런데 아래의 Tensorflow 2.x 버전에서의 Python 즉시 실행모드(eager mode)에서 손실(Loss)을 '즉시 계산(eager execution)'해버려서 출력 결과를 보면 numpy=12.0인 Tensor상수 입니다. 여기서 자동 미분을 하려고 하면 문제가 생깁니다. 왜냐하면 자동미분을 하기 위한 함수와 계산 식의 연산 과정과 입력 값에 대한 정보가 즉시실행모드에서는 없기 때문입니다. (입력 값과 연산 과정은 저장 안하고 즉시실행해서 결과만 출력하였습니다.)

2. Tensorflow에서 Gradient Tapes를 이용하여 자동미분 하는 방법

이 문제를 해결하기 위해 Tensorflow는 중간 연산 과정(함수, 연산)을 테이프(Tape)에 차곡차곡 기록해주는 Gradient Tapes를 제공합니다.

with tf.GradientTape() as tape: 를 사용하여 저장할 tape를 지정해주면, 이후의 GradientTape() 문맥 아래의 Tensorflow의 연관 연산 코드는 tape에 저장이 됩니다. 이렇게 tape에 저장된 연산 과정(함수, 연산식)을 가져다가 Tensorflow는 dx=tape.gradient(loss,x)로 후진 모드 자동 미분 방법(Reverse mode automatic differentiation) 방법으로 손실에 대한 x의 미분을 계산합니다. 이렇게 계산된 손실에 대한 x의 미분을 역전파(backpropagation)하여 x의 값을 갱신(update)하는 작업을 반복함으로써 변수 x의 답을 찾아가는 학습을 진행합니다.

위의 (1)번에서 소개한 8.0=2.0*x의 방정식에서는 변수 x-4.0이 됩니다. Tensorflow의 GradientTape()와 tape.gradient()를 사용하여 문제를 해결해 보겠습니다.

처음에 x=10.0에서 train_func를 4회 반복하니 x=4.0으로 답을 잘 찾아갔습니다.

$ y=x^2 $ 라는 함수에서 (Target) y에 대한 (Source) x의 미분 (derivative of target y with respect to source x)을 Tensorflow의 GradientTape.gradient() 메서드를 사용해서 계산해보겠습니다. 우리는 이미 $ \frac{dy}{dx}=2*x $라는 것을 알고 있습니다.

사용 형식: GradientTape.gradient(target, source)

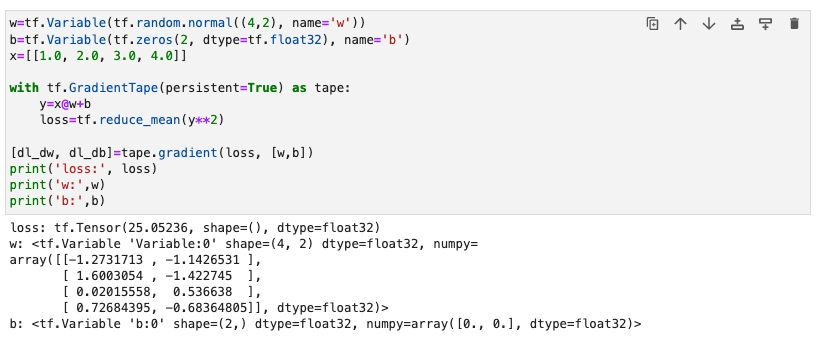

위의 간단한 예제에서는 스칼라(Scalar)를 사용했다면, tf.GradientTape()는 어떤 형태의 텐서에 대해서도 사용할 수 있습니다. GradientTape.gradient(target, sources)에서 sources에는 여러 개 변수를 리스트나 사전형(Dictionary)의 형태로 입력해줄 수 있습니다.

Targetr에 대한 Source의 미분 결과는 Source의 형상(shape)을 따릅니다. 가령, 위의 예에서는 손실함수(Loss)에 대한 가중치(w)의 미분(derivative of loss with respect to weight)의 결과는 Source에 해당하는 가중치(w)의 형상을 따라서 (4, 2)가 됩니다. (해당 위치의 가중치에 대해서 편미분한 결과)

3. 시그모이드 함수의 자동 미분 시각화(Auto-diff plot Sigmoid function)

딥러닝에서 활성화 함수 중의 하나로 사용되는 S 곡선 모양의 시그모이드 함수(Sigmoid function)은 아래와 같습니다.

$$ Sigmoid(x)=\frac{1}{1+e^(-x)}=\frac{e^x}{e^x+1} $$

이 시그모이드 함수를 x에 대해서 미분하면 아래와 같습니다.

$$Derivative\ of\ the\ Sigmoid\ function\ \frac{dS(x)}{dx}=S(x)(1-S(x))$$

시그모이드 함수와 시그모이드 함수의 미분 값을 x가 -10.0에서 10.0 사이의 200개의 관측치에 대해 Tensorflow의 tf.GradientTape()와 GradientTape=tape.gradient(Sigmoid_func, x)로 계산해서 하나의 그래프에 겹쳐서 시각화를 해보겠습니다.

위의 코드에서 주요한 역할은 tape.watch(x)가 합니다.

이것은 GradientTape 내에서 특정 변수의 연산을 "감시"한다는 것을 의미합니다. 그래서 해당 변수에 대한 모든 중간 연산을 레코딩하고, 나중에 그래디언트를 계산할 때 사용할 수 있게 됩니다.

따라서 주어진 코드에는 'x'를 tape.watch(x)로 감시하고 있으며, 이후에 'y=tf.nn.sigmoid(x)'와 같은 연산을 수행하면서 중간 연산을 기록합니다. 그런 다음 tape.gradient(y, x)를 호출하여 'y'에 대한 'x'의 그래디언트를 계산합니다.

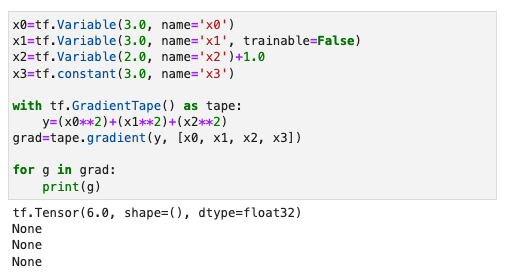

4. 테이프가 "볼(저장)"것을 조정하는 방법(Controlling what the tape "watches")

Tensorflow가 오차역전파 알고리즘으로 학습(training by backpropagation algorithm)할 때 사용하는 자동미분은 '학습 가능한 변수 (trainable tf.Variable)'을 대상으로 합니다.

따라서 만약 (1) 변수가 아닌 상수 ('tf.Tensor')라면 Tensorflow가 안 보는 (not watched), 즉 기록하지 않는 (not recorded)것이 기본 설정이므로 자동 미분을 할 수 없으며, (2) 변수(tf.Variable)더라도 '학습 가능하지 않으면 (not trainable)' 자동 미분을 할 수 없습니다.

y에 대한 tf.Tensor인 x의 미분을 구하기 위해서는 GradientTape.watch(x)를 호출해서 tf.Tensor인 x를 테이프에 기록해주면 됩니다.

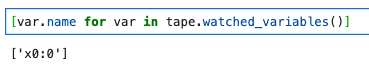

또한 Tensorflow의 테이프에 기록되는 '학습 가능한 변수'는 GradientTape.watched_variables() 메서드로 확인이 가능합니다.

해당 코드는 위의 코드를 확인 한 것은 아닙니다. 만약 위의 코드를 확인하려고 하면 아무 값도 나오지 않을 것입니다.

그 이유는 x를 tf.constant로 선언한 부분에 있습니다. constant는 상수로써 변할 수 없기 때문입니다.

반대로, 모든 변수 (tf.Variable)를 테이프에 기록하는 Tensorflow의 기본설정을 비활성화하려면 watch_accessed_variables=False로 매개변수를 설정해주면 됩니다.

아래의 예시에서는 x0, x1 두 개의 tf.Variable 모두를 watch_accessed_variables=False로 비활성화해놓고, GradientTape.watch(x1)로 x1변수만 테이프에 기록해서 자동 미분을 합니다.

5. Python 조건절을 사용한 테이프 기록 흐름을 조정

Python의 조건절을 이용한 분기문을 이용하면 Tensorflo의 tf.GradientTape() 맥락 아래에서 테이프에 기록하는 연산 과정을 흐름을 조건절에 해당하는 것만 취사선택에서 기록할 수 있습니다.

아래의 예시에서는 if x > 0.0일 때는 result=v0, 그렇지 않을 때(else)는 result=v1**2로 result의 연산을 다르게 해서 테이프에 기록하고, GradientTape.gradient()로 자동미분할 때는 앞서 if else 에서 True에 해당되어 실제 연산이 일어났던 미분을 연결해서 계산하라는 코드를 작성했습니다.

또한 x=tf.constant(1.0)으로써 if x > 0.0 조건절을 만족(True)시켰으므로 result=v0 연산이 실행되고 뒤에 tape.gradient()에서 자동미분이 되었으며, else 조건절 아래의 연산을 실행되지 않았으므로 뒤의 tape.gradient()의 자동미분은 해당되지 않았습니다.

'🖥️ Computer Vision' 카테고리의 다른 글

| 유사도 행렬의 생성 매커니즘의 이해 (0) | 2026.01.09 |

|---|---|

| ReLU를 위한 파트너, He 초기화 (He Initialization) (2) | 2025.09.04 |

| TIF 파일이란? (0) | 2023.06.25 |

- Total

- Today

- Yesterday

- 딥러닝

- LossFunction

- code

- GradientDescent

- 특징융합

- imbalanceddata

- eigenvector

- Example

- 경량화 모델

- PCA

- DeepLearning

- AdamOptimizer

- classimbalance

- 다중세밀도

- CriticV

- depthwise

- fisherconsistency

- vlm

- convolution

- GradientScaling

- tensorflow

- ScientificReports

- Focal loss

- Optimizer

- MGFA

- separable

- MobileNet

- 논문리뷰

- logitadjustment

- 선형대수

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |